亲爱的读者朋友们,

👋 欢迎阅读本期 BestBlogs.dev 的精选文章推送!

🚀 本期我们深入探讨人工智能的最新突破、创新应用和行业动态。从模型进展到开发工具,从跨界应用到市场策略,我们为您精选了最具价值的内容,助您把握 AI 发展脉搏。

🔥 AI 模型:突破性进展

1.Google Gemini 1.5 Pro:200 万词元上下文窗口,代码执行能力

2.阿里 FunAudioLLM:开源语音大模型,提升自然语音交互体验

3.Meta Chameleon:混合模式 AI 模型,在某些任务中优于 GPT-4

4.Moshi:法国 kyutai 实验室开发的原生多模态 AI 模型,接近 GPT-4o 水平

5.字节跳动 Seed-TTS:高质量语音生成大模型,可模仿人类说话特征

💡 AI 开发:工具、框架与 RAG 技术创新

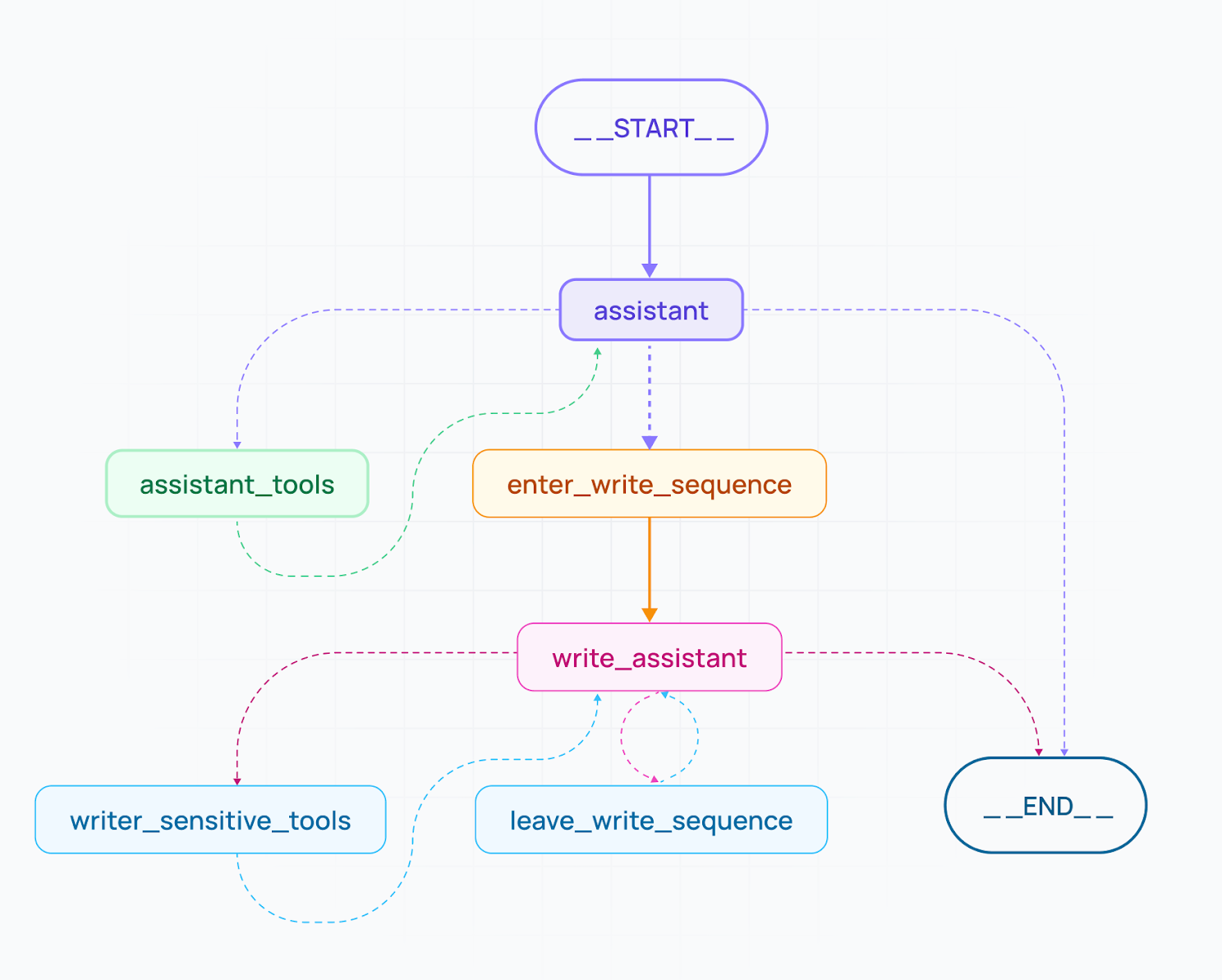

1.LangGraph v0.1 和 Cloud:为复杂 AI 代理系统开发铺平道路

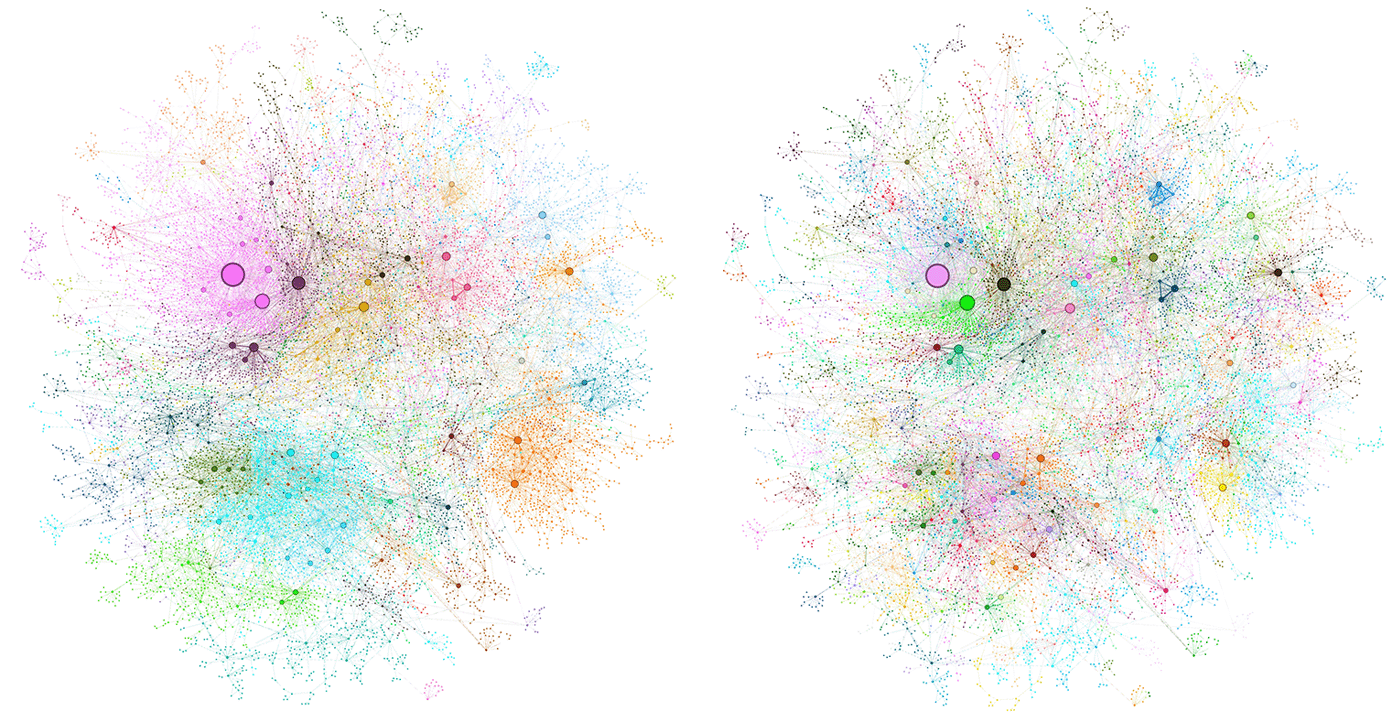

2.GraphRAG:微软开源工具,用于复杂数据发现和知识图谱构建

3.Kimi 上下文缓存技术:显著降低长文本大模型使用成本和响应时间

4.Jina Reranker v2:针对代理 RAG 的神经重排器模型,支持多语言和代码搜索

5.蚂蚁金服 Graph RAG 框架:结合知识图谱技术提高问答质量

🏢 AI 产品:跨界应用显身手

1.腾讯元宝 AI 搜索升级:推出深度搜索模式,提供结构化、丰富的回答

2.ThinkAny:个人开发者艾逗笔开发的 AI 搜索引擎,利用 RAG 技术

3.Replika:AI 情感伴侣,通过记忆功能建立深厚的情感连接

4.AI 在手语翻译领域的应用:如 Signapse、PopSign 等改善听障人士生活

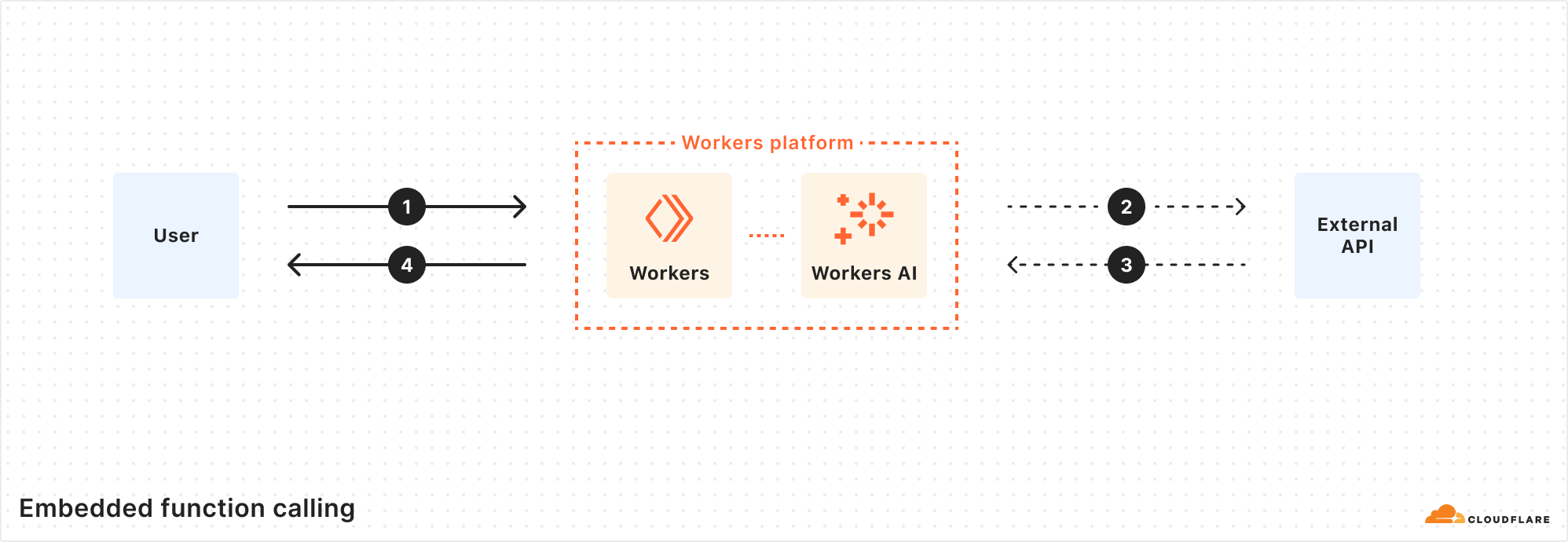

5.Agent Cloud 与 Google Sheets 构建 RAG 聊天机器人:详细实施指南

📊 AI 资讯:市场动态与未来展望

1.比尔·盖茨访谈:AI 将在合成生物学和机器人技术等领域成为主导力量

2.腾讯汤道生谈 AI 战略:AI 不止于大模型,注重全面布局和产业应用

3.Gartner 研究:AIGC 在企业中实现价值的四大关键能力

4.AI 产品定价策略:探讨 SaaS、交易撮合等九种商业模式及其关键指标

5.为什么这一波 AI 创业还值得干?探讨 AI 技术改变供给,创造新的市场机会

本期内容涵盖 AI 前沿技术、创新应用和市场洞察,为开发者、产品经理和 AI 爱好者提供全面深入的行业视角。我们特别关注了 RAG 技术的实践经验和最新进展,为您提供了宝贵的技术参考。无论您是技术专家还是商业决策者,这里都有助您把握 AI 发展方向的关键信息。让我们一起探索 AI 的无限可能,共创智能化未来!